Comparatif des méthodes NLP pour réseaux sociaux : lexique, modèles supervisés, deep learning et LLM pour détecter tendances et signaux faibles.

Les réseaux sociaux produisent chaque jour des millions de contenus. Mais comment transformer ce flot de données en informations utiles ? Le NLP (traitement du langage naturel) propose des solutions efficaces pour analyser et prédire les tendances. Voici les principales méthodes abordées :

Le choix de la méthode dépend de vos objectifs : rapidité, précision, gestion du contexte ou traitement à grande échelle. Par exemple, une analyse lexicale suffit pour surveiller des mots-clés, tandis que des modèles hybrides sont préférables pour détecter des signaux faibles ou analyser des tendances complexes.

L'analyse lexicale repose sur l'attribution d'une note (+1, 0, -1) à chaque mot en fonction de sa polarité, puis sur l'addition de ces scores pour déterminer l'orientation générale d'un message. Cette méthode s'appuie sur des ressources comme SentiWordNet ou des lexiques conçus spécialement pour un contexte précis.

Entre septembre 2016 et mai 2017, la plateforme #Ideo2017 a utilisé cette technique pour examiner 42 290 tweets provenant de 11 candidats à la présidentielle française. Les résultats étaient actualisés toutes les 24 heures, permettant de suivre en temps réel l'évolution de termes politiques clés comme « travail », « sécurité » ou « immigration ». Cette capacité à traiter rapidement des données illustre un des avantages majeurs de cette méthode.

La précision constitue cependant un point faible de cette approche. Lors du défi DEFT 2018, en mai 2018, un système lexical analysant 7 816 tweets français sur les transports publics a atteint un F1-score de 0,64524 grâce à 126 mots-clés adaptés, comme « retard » pour signaler une connotation négative. Cependant, lorsque les chercheurs ont tenté d'identifier des polarités mixtes, la performance est tombée à 0,61. Ce problème est dû à une incapacité à saisir le contexte, car les systèmes lexicaux ne prennent pas en compte les nuances du sujet étudié.

Par exemple, le mot « email », généralement neutre, est devenu un terme à connotation négative dans le contexte de la campagne d'Hillary Clinton en 2016. Les dictionnaires statiques ne peuvent pas s'adapter à ces variations contextuelles, ni gérer efficacement le sarcasme ou l'ironie.

L'analyse lexicale est particulièrement performante lorsqu'il s'agit de traiter d'importants volumes de données. En novembre 2016, des chercheurs des universités Ibn Tofail et d'Angers ont analysé 3 600 000 tweets en seulement deux jours (6–7 novembre) pour prédire les tendances de l'élection présidentielle américaine. Ils ont utilisé une architecture Big Data combinant Apache Kafka et Spark afin de classifier l'opinion publique en sept catégories, allant de « très positif » à « très négatif ».

Cette rapidité de traitement en fait un outil idéal pour analyser en temps réel les flux de données provenant des réseaux sociaux. Avec environ 80 % des données en ligne sous forme de texte non structuré, cette capacité à gérer rapidement de grandes quantités d'informations représente un atout majeur.

Pour pallier les lacunes contextuelles, certains systèmes avancés intègrent des règles spécifiques, comme l'inversion de polarité après des mots de négation (« non », « pas », « rien ») jusqu'à la prochaine ponctuation, ou encore des ajustements pour des mots en majuscules ou avec des lettres répétées (par exemple, « loooove »). D'autres chercheurs développent des dictionnaires dynamiques basés sur des hashtags populaires afin d'adapter l'analyse à des sujets précis. Cependant, cette personnalisation demande un travail manuel conséquent .

Ces limites ont conduit à l'exploration de modèles plus avancés, tels que les approches supervisées et les réseaux de neurones, qui permettent de surmonter certains des défis identifiés avec l'analyse lexicale.

L’apprentissage supervisé marque un tournant décisif en dépassant les limites des simples approches lexicales, grâce à l’utilisation de données annotées qui permettent d’améliorer la précision des prédictions.

Les modèles supervisés se distinguent par leur capacité à apprendre à partir de données étiquetées, ce qui les rend capables de détecter des schémas complexes dans les contenus des réseaux sociaux. Par exemple, entre septembre 2015 et mai 2017, les chercheuses Thi Bich Ngoc Hoang et Josiane Mothe ont utilisé un classificateur Random Forest pour prédire la diffusion d’histoires de marques telles qu’iPhone, Gucci et Samsung. En exploitant 32 variables (incluant des données utilisateur, temporelles et textuelles), elles ont obtenu une augmentation de la mesure F de 4 % par rapport aux méthodes précédentes.

Bien que précis, ces modèles présentent une limite importante : leur dépendance au domaine d’entraînement. En novembre 2016, une équipe de l’Université Ibn Tofail a analysé 3 600 000 tweets en seulement 48 heures à l’aide d’un classificateur Naïve Bayes intégré à Apache Spark MLlib. Leur objectif était de prédire les tendances de l’élection présidentielle américaine. Les tweets ont été classés en sept catégories de polarité, allant de « très positif » à « très négatif ». Cependant, comme l’a souligné Imane El Alaoui :

« Les méthodes supervisées atteignent une précision relativement élevée dans la détection de la polarité dans le domaine sur lequel elles sont entraînées, mais leur performance chute drastiquement lorsque le même modèle est appliqué à un domaine différent. »

Cette dépendance au contexte oblige à réentraîner les modèles avec des données spécifiques à chaque nouveau domaine, ce qui constitue un défi majeur pour leur mise en œuvre généralisée.

Les modèles supervisés surpassent les approches lexicales en ce qui concerne la prise en compte des nuances contextuelles, à condition de disposer de données d’entraînement adaptées. Les réseaux de neurones convolutifs (CNN) et les modèles bidirectionnels comme BERT permettent de se passer de l’identification manuelle des caractéristiques, atteignant des niveaux de précision pouvant aller jusqu’à 0,97, notamment dans des analyses massives comme les discussions sur la qualité de l’air sur Twitter .

Une autre étude, portant sur 24 millions de tweets, a utilisé une approche supervisée basée sur PageRank pour allouer des utilisateurs à des clusters prédits, atteignant un taux de réussite impressionnant de 96 %. Ce succès démontre que ces modèles peuvent traiter des volumes massifs tout en maintenant une précision élevée. Ils se montrent particulièrement efficaces lorsqu’ils intègrent des éléments comme l’influence des nœuds d’interaction, plutôt que de se limiter à des comptages d’occurrences. Ces avancées ouvrent la voie à une utilisation élargie des réseaux de neurones, qui seront abordés dans la section suivante.

Au-delà de l’analyse textuelle, l’intégration des données utilisateur joue un rôle crucial dans la prédiction des tendances. Dans l’étude sur iPhone, Gucci et Samsung, un résultat inattendu a émergé : les caractéristiques utilisateur, telles que le nombre d’abonnés, l’ancienneté du compte ou encore le nombre de groupes auxquels appartient l’utilisateur, se sont révélées plus importantes pour prédire la diffusion d’une tendance que le contenu textuel lui-même. Cela remet en question l’idée selon laquelle le texte seul suffit pour anticiper les dynamiques sociales. Les modèles supervisés les plus performants combinent désormais des dizaines de variables, intégrant données utilisateur, temporelles et linguistiques, pour maximiser leur efficacité prédictive.

Les réseaux de neurones profonds ont marqué un tournant dans l'analyse des réseaux sociaux en permettant d'extraire automatiquement des caractéristiques complexes.

Les réseaux de neurones convolutifs (CNN) se distinguent par leur capacité à identifier des caractéristiques linguistiques sans intervention humaine. Entre 2017 et 2018, B. Juanals et J.L. Minel ont conçu un classificateur basé sur un CNN pour analyser 4 832 tweets français portant sur la qualité de l'air. Ce modèle, utilisant une architecture Conv1D avec 200 filtres et des embeddings de mots, a atteint une précision impressionnante de 0,97. Il catégorisait les messages dans trois classes : « informatif », « promotionnel » et « humoristique ».

Au-delà de leur précision, ces modèles améliorent aussi la compréhension contextuelle. Les Transformers, comme BERT, se démarquent grâce à leur mécanisme d'auto-attention, qui analyse à la fois les mots précédant et suivant un terme donné. Contrairement aux approches lexicales traditionnelles, souvent limitées au traitement mot à mot, ces architectures bidirectionnelles permettent de capter des nuances sémantiques subtiles. Par exemple, un mot comme « email » peut sembler neutre, mais dans le cadre d’un scandale politique, il peut véhiculer une charge négative. En novembre 2024, Boutaleb et son équipe chez RTE France ont introduit le framework BERTrend, qui intègre l’apprentissage en ligne pour suivre l’évolution des « signaux faibles » vers des « signaux forts » en temps réel. Cette capacité d’analyse contextuelle ouvre la voie à une adaptation plus dynamique et efficace.

Le traitement de volumes massifs de données reste un défi majeur, surtout avec les millions de publications générées chaque seconde sur les réseaux sociaux. Cependant, les modèles Transformer modernes ont été optimisés pour s’exécuter sur du matériel standard, réduisant ainsi la dépendance à des infrastructures cloud coûteuses. Cette accessibilité technique rend possible l’analyse de larges ensembles de données tout en maintenant un haut niveau de précision. Ces avancées s’inscrivent dans une logique d’amélioration continue des approches existantes, rendant ces technologies plus accessibles et performantes.

Les approches strictement lexicales ou supervisées montrent des limites lorsqu'il s'agit d'interpréter le contexte ou de s'adapter à des situations variées. Les modèles hybrides viennent combler ces lacunes en combinant différentes techniques : ils associent la détection de motifs locaux (via les réseaux de neurones convolutifs, CNN) à l'analyse séquentielle du contexte (grâce aux réseaux LSTM). Par exemple, en octobre 2023, l'Université de Valladolid a mis au point un modèle hybride CNN-LSTM pour l'analyse de tweets en espagnol. Ce modèle a atteint une précision de 91 % dans une tâche de classification binaire (positif/négatif).

Les modèles de langage large (LLM) apportent une nouvelle dimension à ces approches en affinant l'interprétation des résultats. Le framework BERTrend, développé par RTE France en novembre 2024, en est un exemple marquant. Il combine BERTopic pour détecter les thématiques initiales, puis s'appuie sur les LLM pour générer des résumés clairs des tendances émergentes. Cette méthode permet d’identifier des « signaux faibles », ces indices précoces souvent ignorés par les modèles traditionnels basés sur des fréquences.

En novembre 2025, des chercheurs de la Sorbonne ont utilisé BERTweet pour analyser 57 millions de tweets dans le cadre du projet Climatoscope. Leur modèle a prédit l’affiliation communautaire avec une précision dépassant 85 %, à partir de seulement trois phrases courtes. Cette capacité à saisir les subtilités linguistiques, comme le sarcasme ou la négation, est particulièrement précieuse pour des langues complexes comme l’espagnol, où ces nuances sont fréquentes sur les réseaux sociaux.

Le traitement de données massives reste un défi majeur, même avec ces nouvelles approches. Les modèles hybrides nécessitent des ressources matérielles conséquentes, comme des GPU dotés d’au moins 16 Go de RAM, pour gérer le flux et l’ampleur des données issues des réseaux sociaux. Pour contourner ces contraintes, de nombreux développeurs privilégient des solutions comme les services d’embeddings distants ou des modèles spécialisés tels que BERTweet. Ces alternatives offrent des performances élevées sans exiger d'infrastructures cloud coûteuses. De plus, des expériences antérieures ont démontré qu’il est possible de traiter des millions de tweets en temps réel grâce à des architectures Big Data optimisées, renforçant ainsi la viabilité de ces approches à grande échelle.

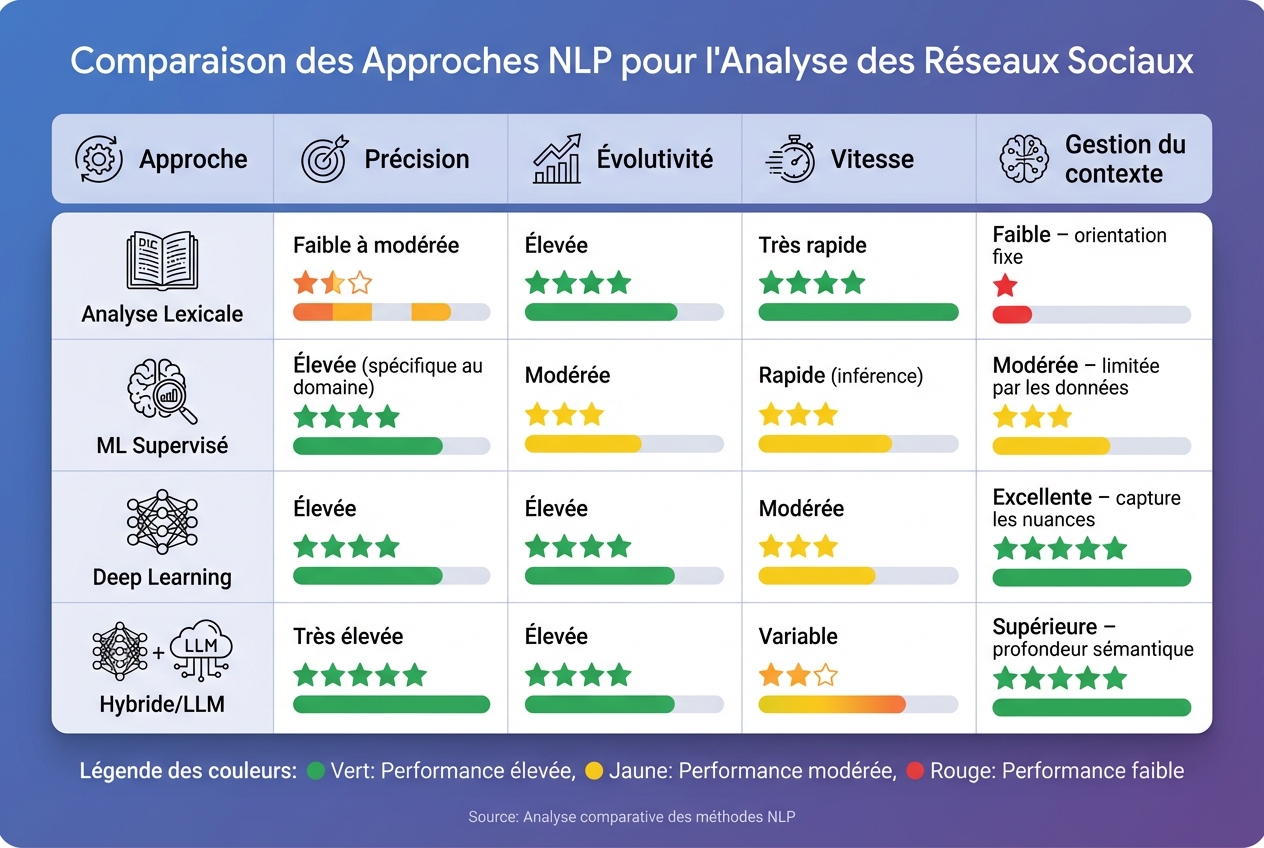

Comparaison des méthodes NLP pour l'analyse des réseaux sociaux

Après avoir étudié chaque méthode en détail, voici un résumé de leurs principaux avantages et limites. Les approches lexicales se distinguent par leur rapidité pour effectuer un premier tri, mais elles peinent à saisir les subtilités contextuelles. Les modèles supervisés, eux, offrent une grande précision dans le domaine spécifique pour lequel ils ont été entraînés, mais leurs performances diminuent lorsqu'ils sont appliqués à un autre contexte. Les réseaux de neurones profonds, quant à eux, nécessitent des volumes de données importants et une puissance de calcul conséquente. Enfin, les approches hybrides utilisant les LLM (modèles de langage de grande taille) combinent une compréhension contextuelle avancée et une précision accrue, bien que leur mise en œuvre reste plus complexe.

Voici un tableau comparatif qui synthétise les forces et les faiblesses de chaque approche :

| Approche | Précision | Évolutivité | Vitesse | Gestion du contexte |

|---|---|---|---|---|

| Lexicale | Faible à modérée | Élevée | Très rapide | Faible – orientation fixe |

| ML supervisé | Élevée (spécifique) | Modérée | Rapide (inférence) | Modérée – limitée par les données |

| Deep Learning | Élevée | Élevée | Modérée | Excellente – capture les nuances |

| Hybride/LLM | Très élevée | Élevée | Variable | Supérieure – profondeur sémantique |

Le choix de la méthode dépend donc des besoins spécifiques. Les approches lexicales sont idéales pour un tri rapide, les modèles supervisés conviennent à une classification fiable dans des domaines bien définis, tandis que le deep learning et les LLM se prêtent mieux à l’analyse de flux massifs en temps réel, avec une compréhension contextuelle approfondie .

Comme nous l'avons vu, il est essentiel d'adapter votre stratégie NLP à vos objectifs spécifiques. Par exemple, pour la surveillance de mots-clés, une analyse lexicale rapide est souvent suffisante. En revanche, pour détecter des signaux faibles ou analyser des données complexes, les modèles hybrides combinant deep learning et LLM sont plus appropriés. Ces choix technologiques s'inscrivent dans un contexte de croissance rapide du marché de l'IA, qui devrait passer de 2,69 milliards de dollars en 2025 à 9,25 milliards de dollars en 2030, avec une croissance annuelle de 28,04 %. Cette tendance illustre l'adoption croissante des solutions NLP, particulièrement dans des secteurs comme le marketing et la vente, qui représentaient à eux seuls 48,3 % des revenus en 2024.

Un excellent exemple de l'application de ces technologies est BERTrend, présenté par RTE France en novembre 2024 et intégré à Netminer 5 l'année suivante. Cet outil montre comment transformer des volumes massifs de données en informations stratégiques exploitables. Cependant, au-delà des avancées techniques, une mise en œuvre réussie repose sur une collaboration efficace et des solutions adaptées aux besoins spécifiques.

Pour les entreprises qui ne disposent pas d'une expertise interne, Zetos propose un accompagnement complet, allant de la conception à la mise en œuvre opérationnelle de produits d'IA sur mesure. Grâce à des architectures modulaires basées sur Docker, des bibliothèques Python spécialisées et des configurations automatisées, Zetos facilite l'intégration des modèles NLP dans les processus existants .

De plus, les API low-code et les services managés démocratisent ces technologies, les rendant accessibles même aux petites entreprises, sans nécessiter d'infrastructures coûteuses. Par exemple, les outils NLP surpassent les filtres traditionnels de 73 % en matière de détection de toxicité, prouvant leur efficacité dans des cas d'usage concrets. Que vous cherchiez à surveiller votre réputation en ligne, à identifier les tendances de consommation ou à optimiser vos campagnes publicitaires, il est crucial de choisir une solution qui correspond à vos besoins spécifiques, plutôt que de simplement opter pour l'option la plus sophistiquée.

Les approches hybrides en NLP mélangent des modèles statistiques, comme ceux basés sur l’apprentissage profond, avec des techniques symboliques ou fondées sur des règles. Cette combinaison permet de tirer parti des points forts de chaque méthode, ce qui s'avère particulièrement utile pour analyser des contenus issus des réseaux sociaux, souvent courts et dépourvus de contexte.

Ces méthodes offrent plusieurs avantages notables. Elles permettent une analyse plus précise et s'adaptent facilement à différents contextes linguistiques. Par exemple, elles sont particulièrement efficaces pour identifier des tendances émergentes sur des plateformes comme Twitter ou Instagram. En plus, elles fournissent des évaluations en temps réel, ce qui est essentiel pour suivre l'évolution rapide des discussions en ligne.

Cependant, ces approches ne sont pas sans contraintes. Leur mise en place demande des compétences techniques avancées, ce qui peut représenter un obstacle pour certaines entreprises. De plus, elles impliquent des coûts de calcul élevés et peuvent être complexes à développer et à maintenir sur le long terme.

Pour les entreprises souhaitant exploiter ces technologies, Zetos propose des solutions NLP personnalisées. Ces services sont conçus pour répondre aux besoins spécifiques des entrepreneurs français et les aider à maximiser leur présence numérique et leur impact sur les réseaux sociaux.

Les réseaux de neurones profonds permettent d'explorer les réseaux sociaux avec une précision impressionnante. Leur force réside dans leur aptitude à décoder des textes courts et complexes, souvent enrichis d'éléments comme les emojis, les abréviations ou les hashtags. En s'entraînant sur d'immenses volumes de données, ces modèles parviennent à saisir des nuances sémantiques et émotionnelles, rendant les analyses plus fines et détaillées.

Ces technologies trouvent aujourd'hui des applications variées : détection de tendances, analyse de sentiment ou encore modération de contenu en temps réel. Prenons l'exemple des modèles basés sur les Transformers. Spécialisés dans le traitement du langage des réseaux sociaux, ils permettent des tâches comme la prédiction d'emojis ou l'identification de langage offensant, des outils essentiels pour des analyses rapides et précises.

Chez Zetos, ces innovations sont mises à profit pour concevoir des solutions sur mesure. Ces outils aident les entrepreneurs à mieux cerner leur audience, ajuster leurs campagnes marketing et optimiser leur présence en ligne. En combinant expertise en intelligence artificielle et développement full-stack, Zetos transforme les données issues des réseaux sociaux en outils stratégiques, parfaitement adaptés aux besoins spécifiques de chaque client.

Opter pour une méthode NLP adaptée est essentiel pour atteindre vos objectifs, qu'il s'agisse d'analyser les sentiments, de classer des sujets ou de prédire des tendances sur les réseaux sociaux. Chaque tâche repose sur des techniques spécifiques : par exemple, la tokenisation et l'analyse syntaxique permettent de décortiquer la structure d'un texte, tandis que les modèles de deep learning capturent des nuances complexes et prédisent des comportements avec une précision accrue.

Utiliser une méthode inadaptée peut entraîner des biais, une perte de précision ou des dépenses inutiles. De plus, le NLP appliqué au français doit tenir compte de ses particularités, comme les accents, les expressions familières ou encore les emojis. Les modèles de langage avancés offrent une compréhension contextuelle approfondie, indispensable pour détecter des tendances émergentes et extraire des informations clés.

Chez Zetos, nous aidons les entrepreneurs à identifier et déployer les meilleures approches NLP. Notre expertise transforme les données issues des réseaux sociaux en opportunités stratégiques, tout en optimisant leur retour sur investissement.