Limiter la consommation des GPU est indispensable : quantification 4 bits, plafonnement de puissance et optimisation logicielle peuvent réduire l'énergie jusqu'à 54%.

Conclusion : Réduire la consommation énergétique des GPU est crucial pour limiter les coûts, l'empreinte carbone et rendre l'IA plus accessible, tout en maintenant des performances élevées.

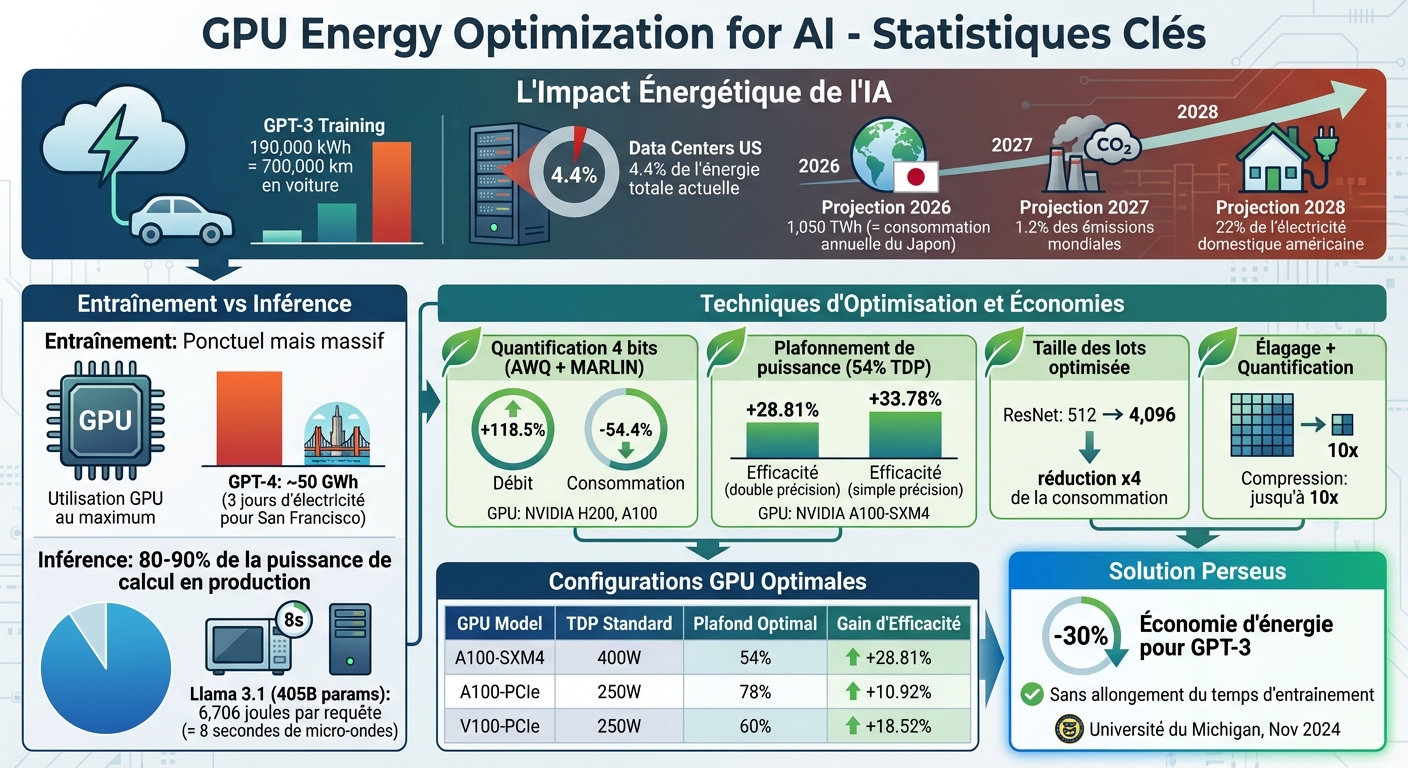

Optimisation énergétique des GPU pour l'IA : statistiques clés et économies d'énergie

La consommation énergétique d’un GPU dépend principalement de sa fréquence d’horloge, de ses limites de puissance et de la gestion thermique. Une fréquence élevée, même sans charge de calcul importante, peut augmenter la consommation d’énergie.

Un des problèmes majeurs réside dans la répartition inégale des charges de travail entre plusieurs GPU. Lorsqu’une tâche d’entraînement est répartie sur des milliers de processeurs, certains terminent leurs calculs plus rapidement que d’autres. Les GPU les plus rapides continuent alors à tourner à pleine puissance en attendant que les plus lents finissent leur travail. Ce déséquilibre entraîne un gaspillage énergétique notable.

La taille des lots joue également un rôle clé dans l’efficacité énergétique. Par exemple, avec ResNet, augmenter la taille des lots de 512 à 4 096 peut réduire la consommation énergétique d’un facteur 4. Cela permet aux GPU d’utiliser pleinement leurs cœurs de calcul, diminuant ainsi l’énergie consommée par token traité.

Le TDP (Thermal Design Power) est une mesure de la puissance thermique maximale qu’un GPU peut dissiper. Cependant, cette valeur ne reflète pas toujours la consommation réelle. Par exemple, un nœud NVIDIA H100 HGX équipé de 8 GPU a été mesuré à une puissance maximale de 8,4 kW, soit 18 % de moins que les 10,2 kW annoncés par le fabricant.

Une métrique plus pertinente pour évaluer l’efficacité énergétique est la performance par watt (Gflop/s/Watt). Elle mesure le rapport entre la puissance de calcul et l’énergie consommée. En janvier 2025, des chercheurs de l’Université de Bordeaux et de l’Inria ont montré qu’en limitant les GPU NVIDIA A100 à 54 % de leur TDP, ils réalisaient une économie d’énergie de 28,81 % lors de multiplications matricielles en double précision.

La bande passante mémoire, qui mesure la vitesse de lecture et d’écriture des données dans la VRAM, constitue souvent un goulot d’étranglement, particulièrement lors de l’inférence ou de l’entraînement avec de petits lots. Les états de puissance (P-States) permettent de réguler la tension et la fréquence en fonction de l’utilisation. Par exemple, le mode P0 correspond aux performances maximales, tandis que le mode P8 est utilisé pour le mode veille. Ces métriques montrent clairement les variations de consommation entre les phases d’entraînement et d’inférence.

L’entraînement et l’inférence diffèrent considérablement en termes de consommation énergétique. L’entraînement est une opération ponctuelle mais massive, où les serveurs fonctionnent à plein régime pendant des mois, avec une utilisation GPU proche de son maximum. À titre d’exemple, l’entraînement de GPT-4 aurait consommé environ 50 gigawatts-heures (GWh), soit de quoi alimenter San Francisco pendant trois jours.

L’inférence, bien qu’elle consomme moins d’énergie par requête individuelle, devient le principal poste de consommation énergétique en production. On estime que 80 à 90 % de la puissance de calcul dédiée à l’IA est utilisée pour l’inférence. Par exemple, chaque requête adressée à un modèle de 405 milliards de paramètres, tel que Llama 3.1, consomme environ 6 706 joules (en tenant compte du refroidissement et du CPU), ce qui équivaut à faire fonctionner un micro-ondes pendant 8 secondes.

"Pour qu'une entreprise gagne de l'argent avec un modèle, cela ne se produit que lors de l'inférence."

- Esha Choukse, Chercheuse, Microsoft Azure

Après avoir exploré l'impact matériel des GPU sur la consommation énergétique, intéressons-nous aux solutions logicielles. Ces méthodes permettent d'optimiser l'efficacité énergétique des GPU sans compromettre les performances des modèles d'IA. Elles interviennent directement sur la façon dont les calculs sont réalisés et sur la gestion des données entre la mémoire et les cœurs de calcul.

La quantification est une technique qui consiste à convertir les poids d'un modèle d'une précision élevée (comme le bfloat16 sur 16 bits) vers une précision plus basse (8 bits ou même 4 bits). Cette réduction diminue à la fois l'empreinte mémoire et l'énergie nécessaire pour transférer les données entre la VRAM et les caches. En effet, le coût énergétique d'un multiplieur dépend de manière quadratique du nombre de bits (O(b²)), ce qui rend cette approche particulièrement efficace.

En septembre 2025, Malek Belkahla (ENSTA Paris) et Gaetan Hains (LACL) ont démontré que l'application de la quantification AWQ (Activation-aware Weight Quantization) sur 4 bits, combinée au noyau MARLIN, augmentait le débit d'inférence des modèles Mistral-7B et 24B de 118,5 %, tout en réduisant la consommation énergétique de 54,4 % sur des GPU NVIDIA H200 et A100. Cette méthode préserve les poids « saillants » (moins de 0,1 % des poids ayant une forte influence sur les performances) tout en quantifiant le reste.

"Le débit est augmenté jusqu'à 118,5 % tandis que la consommation d'énergie est réduite jusqu'à 54,4 %, le tout sans dégradation catastrophique de la précision du modèle."

- Malek Belkahla, ENSTA Paris

La sparsité, ou élagage, est une autre méthode clé. Elle consiste à mettre à zéro les poids de faible magnitude, qui ont peu d'impact sur la précision du modèle. Cela réduit le nombre de paramètres et les ressources de calcul nécessaires. Lorsqu'on combine élagage et quantification, il est possible de compresser les modèles jusqu'à 10 fois leur taille d'origine.

Le DVFS (Dynamic Voltage and Frequency Scaling) est une méthode qui ajuste dynamiquement la tension et la fréquence de fonctionnement du GPU en fonction de la charge de travail. Les GPU modernes permettent de plafonner leur puissance via des outils comme la bibliothèque NVML de NVIDIA ou nvidia-smi. Cela permet au firmware de gérer automatiquement la tension et la fréquence pour respecter la limite définie.

En janvier 2025, Albert d'Aviau de Piolant (Université de Bordeaux) a utilisé le runtime StarPU pour optimiser l'efficacité énergétique sur une plateforme équipée de quatre GPU NVIDIA A100-SXM4. En plafonnant statiquement la puissance à 54 % du TDP, son équipe a amélioré l'efficacité énergétique des multiplications matricielles de 24,3 % en double précision et de 33,78 % en simple précision, malgré une baisse de performance de 26,41 %.

"La meilleure efficacité énergétique est atteinte lorsque le plafonnement de puissance est fixé en dessous du TDP, quelle que soit la taille de la matrice et la précision."

- Albert d'Aviau de Piolant, Université de Bordeaux

Les noyaux gourmands en calcul, comme GEMM, peuvent gagner jusqu'à 30 % en efficacité énergétique lorsque le GPU est plafonné entre 55 et 70 % de son TDP. Cette approche se révèle particulièrement utile pour les tâches où une légère baisse de performance est acceptable.

Au-delà des ajustements matériels, l'optimisation des charges de travail joue également un rôle important. Par exemple, ajuster la taille des lots permet de minimiser le produit énergie-délai (EDP), en équilibrant débit et consommation énergétique. Une taille de lot plus grande exploite mieux le parallélisme du GPU, saturant les cœurs de calcul et augmentant le taux de génération de tokens. En revanche, des tailles de lots plus petites, souvent utilisées pour des applications sensibles à la latence comme les chatbots, sont limitées par la bande passante mémoire.

La fusion de noyaux est une autre technique efficace. Elle combine plusieurs opérations simples (comme addition, multiplication ou sigmoid) en un seul noyau, réduisant ainsi les accès mémoire et les latences de lancement. Les frameworks modernes comme PyTorch 2.0+ utilisent des compilateurs (TorchInductor via torch.compile) pour automatiser cette fusion. Cette méthode est particulièrement utile pour les opérations limitées par la mémoire.

| Technique | Bénéfice principal | Impact énergétique |

|---|---|---|

| Quantification (4 bits) | Réduction de la bande passante mémoire | Jusqu'à 54,4 % de réduction |

| Élagage (Sparsité) | Réduction du nombre de paramètres | Compression jusqu'à 10× |

| Plafonnement de puissance | Limitation de la consommation maximale | Jusqu'à 30 % de gain d'efficacité |

| Fusion de noyaux | Réduction des accès mémoire | Amélioration variable selon la charge |

Une fois les optimisations logicielles effectuées, le matériel joue un rôle clé pour atteindre une efficacité énergétique optimale. Deux éléments méritent une attention particulière : le choix du GPU adapté et la gestion thermique du système.

Les dernières architectures, comme les NVIDIA Hopper H100 et H200, apportent des avancées notables grâce à des Tensor Cores améliorés et une gestion mémoire optimisée. Toutefois, il est crucial de considérer le TDP (Thermal Design Power) et les performances sous plafonnement. Par exemple, le H200, avec ses 141 Go de mémoire HBM3e, offre une bande passante accrue, réduisant ainsi les goulots d'étranglement mémoire, un obstacle fréquent dans le traitement des grands modèles de langage.

En janvier 2025, Albert d'Aviau de Piolant (Université de Bordeaux/Inria) a démontré qu'avec les GPU NVIDIA A100-SXM4, réduire le TDP à 54 % (216 W au lieu de 400 W) permettait un gain d'efficacité énergétique de 28,81 %, malgré une baisse de performances de 22,93 %.

"Plus rapide n'équivaut pas à être économe en énergie. Au contraire, lorsque l'efficacité énergétique est l'objectif, il est préférable de réduire la limite de puissance."

- Albert d'Aviau de Piolant, Université de Bordeaux/Inria

| Modèle GPU | Architecture | TDP standard | Plafond optimal (% du TDP) | Gain d'efficacité |

|---|---|---|---|---|

| NVIDIA A100-SXM4 | Ampere | 400 W | 54 % (double précision) | 28,81 % |

| NVIDIA A100-PCIe | Ampere | 250 W | 78 % (double précision) | 10,92 % |

| NVIDIA V100-PCIe | Volta | 250 W | 60 % (double précision) | 18,52 % |

La compatibilité avec les formats de quantification en basse précision, comme l'AWQ 4 bits, est également cruciale. Ces formats permettent de réduire la consommation énergétique jusqu'à 54,4 %, tout en augmentant le débit de calcul.

Le refroidissement représente une part importante de la consommation énergétique dans les data centers. Les systèmes haute densité, tels que le DGX H100, nécessitent un débit d'air élevé (1 105 CFM) et génèrent une chaleur importante, équivalente à 38 557 BTU/h. Dans ces configurations, le refroidissement liquide direct (DLC) devient une solution incontournable, car il réduit la consommation des ventilateurs et limite la chaleur ambiante.

Maintenir les GPU à une température comprise entre 5 °C et 30 °C est essentiel pour éviter le throttling thermique. Un système mal refroidi force le GPU à diminuer ses performances, allongeant ainsi le temps d'exécution et augmentant paradoxalement la consommation énergétique globale.

L'adoption croissante du DLC dans les clusters H100 et H200 illustre cette tendance. En transférant la chaleur via des liquides plutôt que par convection d'air, les data centers parviennent à réduire leur consommation énergétique tout en augmentant leur densité de calcul.

Une fois le matériel et le système de refroidissement optimisés, trois étapes essentielles permettent de garantir une utilisation efficace de l'énergie : surveiller précisément la consommation, ajuster les charges et effectuer des benchmarks.

Mesurez la consommation énergétique réelle en temps réel. Le TDP (Thermal Design Power) ne reflète pas toujours la consommation moyenne réelle. Pour les GPU NVIDIA Volta ou plus récents, l'API nvmlDeviceGetTotalEnergyConsumption peut fournir l'énergie totale consommée en millijoules depuis le chargement du pilote. Pour les modèles plus anciens, vous pouvez interroger nvmlDeviceGetPowerUsage de manière continue et calculer la consommation sur une période donnée.

Avant de prendre des mesures finales, assurez-vous de synchroniser le CPU et le GPU (par exemple, via torch.cuda.synchronize() en PyTorch). Des outils comme ZeusMonitor simplifient ces processus en détectant automatiquement l'architecture, en choisissant l'API adaptée et en synchronisant les mesures.

« Sur les GPU A100 et H100, seulement 25 % du temps d'exécution est échantillonné pour la consommation électrique... cela peut conduire à une sous-estimation ou surestimation drastique de l'énergie consommée. » - Zeyu Yang et al., Université d'Oxford

Les mesures logicielles (via Nvidia-smi ou RAPL) restent approximatives, avec une marge d'erreur de 16 % par rapport aux wattmètres. Pour un suivi à grande échelle, vous pouvez exporter les données de Zeus vers Prometheus. Cela permet de visualiser la consommation énergétique à long terme grâce à des histogrammes, des jauges et des compteurs pour suivre l'énergie utilisée.

Une fois la consommation bien mesurée, vous pouvez ajuster les charges pour maximiser l'efficacité.

Limiter la puissance maximale peut considérablement améliorer l'efficacité énergétique. Par exemple, pour des tâches intensives comme GEMM, régler le GPU à 55-70 % de son TDP peut réduire la consommation tout en améliorant l'efficacité énergétique de 30 %. Sur une plateforme à 4 GPU, cette méthode a permis d'améliorer l'efficacité énergétique de 24,3 % pour les calculs en double précision et de 33,78 % pour ceux en simple précision.

D'autres optimisations incluent l'activation de TF32 (via torch.backends.cuda.matmul.allow_tf32 = True) et l'utilisation de formats comme FP16 ou BF16 pour alléger la charge de calcul et la bande passante mémoire.

Pour tirer parti des Tensor Cores, utilisez des tailles de batch multiples de 8 (ou 64 pour les GPU A100 et H100). Activez également le chargement asynchrone des données avec num_workers > 0 et pin_memory=True pour éviter que le GPU ne reste inactif en attendant les données du CPU. Évitez les opérations qui forcent la synchronisation entre le CPU et le GPU, comme .item(), .cpu() ou print(cuda_tensor), afin de maintenir une utilisation fluide des ressources.

Ces ajustements doivent être validés par des benchmarks pour déterminer le meilleur équilibre entre performance et consommation.

Le produit énergie-délai (EDP) est un indicateur clé pour équilibrer performance et consommation. Il aide à identifier les configurations idéales, comme la taille de batch ou la fréquence d'horloge. En septembre 2025, Malek Belkahla (ENSTA Paris) et Gaétan Hains (UPEC) ont démontré qu'en utilisant la quantification AWQ et l'outil pynvml, il était possible d'augmenter le débit de 118,5 % tout en réduisant la consommation de 54,4 % sur un cluster HPC AUSTRAL. Leur étude, basée sur le framework lm-eval, a validé ces résultats sur des benchmarks comme ARC Challenge et MMLU, tout en maintenant la précision des modèles.

Pour des mesures encore plus précises, des wattmètres externes (comme ceux d'Omegawatt) peuvent capturer la consommation totale du système, y compris les composants non suivis par logiciel. Tester différents profils de charge, comme des générations courtes (128 tokens pour des chatbots) et longues (1 024 tokens pour des résumés), permet de mieux comprendre comment l'efficacité énergétique varie en fonction de la tâche.

L'optimisation énergétique des GPU dans l'IA n'est pas un simple choix, mais une priorité stratégique. En novembre 2024, l'équipe dirigée par le professeur Mosharaf Chowdhury de l'Université du Michigan a prouvé, grâce à l'outil Perseus, qu'il était possible d'entraîner des modèles comme GPT-3 tout en consommant 30 % d'énergie en moins. Et tout cela sans allonger le temps d'entraînement, notamment en réduisant le gaspillage dû à une mauvaise répartition des tâches entre processeurs. Ces résultats montrent clairement comment de meilleures pratiques énergétiques peuvent à la fois améliorer les performances et renforcer la durabilité des systèmes d’IA.

"If we can reduce the energy consumed by AI, we can reduce AI's carbon footprint and cooling requirements and allow for more computation to fit within our current energy constraints." - Mosharaf Chowdhury, Associate Professor of Computer Science and Engineering, University of Michigan

En optimisant la consommation énergétique, non seulement vous réduisez vos coûts d'électricité et de refroidissement, mais vous contribuez aussi à limiter l'empreinte carbone des data centers. Ces infrastructures, selon les prévisions, pourraient représenter 1,2 % des émissions mondiales d'ici 2027. Sur le plan opérationnel, ces pratiques permettent d'augmenter le débit tout en consommant moins, résolvant ainsi le conflit habituel entre performance et efficacité.

Pour équilibrer ces deux aspects, commencez par adopter des méthodes comme la limitation de puissance, la quantification, l’ajustement des tailles de batch et le suivi énergétique en temps réel. Mesurez d'abord votre consommation actuelle, puis appliquez des optimisations adaptées à vos charges de travail. Le véritable équilibre repose sur le produit énergie-délai (EDP), un indicateur clé pour identifier les configurations les plus rentables pour votre infrastructure.

Avec des projections montrant que l’IA pourrait consommer l’équivalent de 22 % de l’électricité domestique américaine d’ici 2028, ces pratiques ne sont plus une option. Elles sont essentielles pour garantir que vos projets d’IA restent économiquement viables et respectueux de l’environnement.

La quantification en 4 bits permet d’optimiser l’utilisation des GPU en compressant la taille des poids des modèles et en réduisant le volume des données à traiter. Résultat : une moindre sollicitation de la mémoire et de la bande passante, ce qui se traduit par une meilleure efficacité énergétique.

Concrètement, cette méthode peut réduire la consommation d’énergie jusqu’à 54 %, tout en maintenant des performances élevées, que ce soit pour l’entraînement ou l’inférence des modèles d’IA. Une approche qui allie puissance de calcul et réduction de l’impact environnemental.

En production, l’objectif est d’assurer des performances optimales avec un débit maximal et une latence réduite au minimum. Cela oblige les GPU à tourner à plein régime en permanence, ce qui entraîne une hausse significative de la consommation d’énergie.

En revanche, l’entraînement des modèles peut être organisé par lots et ajusté à l’aide de stratégies comme la limitation de la puissance ou le réglage de la fréquence des GPU. Ces méthodes permettent de diminuer la consommation énergétique tout en préservant une efficacité suffisante pour l’apprentissage des modèles.

Pour réduire la consommation énergétique des GPU tout en conservant des performances satisfaisantes, commencez par limiter la puissance maximale consommée (power capping). Par exemple, fixer la consommation du GPU à 55-70 % de son TDP peut diminuer l’utilisation d’énergie jusqu’à 30 %, tout en ayant un impact limité sur les performances. Vous pouvez également ajuster légèrement la fréquence d’horloge ou activer les modes « Eco » intégrés aux GPU pour obtenir des économies supplémentaires.

Une autre approche consiste à réduire la précision des calculs. L’adoption de techniques comme la quantisation en 4 bits ou l’utilisation de la mixed-precision (FP16/FP32) peut considérablement abaisser la consommation électrique, tout en maintenant la précision nécessaire pour vos modèles. Ces options sont souvent disponibles dans des bibliothèques comme PyTorch ou TensorFlow.

Enfin, surveiller et planifier les charges GPU est indispensable. Utilisez des outils de monitoring pour suivre la consommation en temps réel, ajustez la taille des lots et optimisez les opérations afin de maximiser l’efficacité. Ces pratiques permettent de réduire les coûts énergétiques (en euros) et de limiter l’empreinte carbone, tout en rendant l’entraînement des modèles plus respectueux de l’environnement.