L'IA automatise le nettoyage, détecte les anomalies, corrige les biais et renforce la gouvernance pour des données fiables et des décisions plus précises.

Les données de mauvaise qualité coûtent cher aux entreprises : jusqu'à 12,9 millions de dollars par an en moyenne selon Gartner. En France, ces pertes touchent la gestion des clients, des stocks ou encore les campagnes marketing. L'IA change la donne : elle automatise le nettoyage, détecte les anomalies et améliore la fiabilité des données en temps réel. Résultat ? Des décisions plus précises, des coûts réduits et des modèles d'IA optimisés. Voici comment l'IA transforme la gestion des données et pourquoi elle est devenue incontournable pour les entreprises françaises.

Malgré l'importance accordée à la qualité des données, seulement 12 % des entreprises jugent leurs données suffisamment fiables pour soutenir efficacement leurs projets d'IA. Pire encore, 77 % des organisations qualifient la qualité de leurs données de « moyenne » ou pire, contre 66 % l'année précédente. Ces chiffres montrent une dégradation continue, causée par des défis techniques et organisationnels. Cela souligne l'urgence d'améliorer ces deux aspects pour garantir des données fiables.

Les grandes entreprises françaises sont confrontées à de nombreux problèmes qui compromettent la fiabilité de leurs données. Parmi eux, les données manquantes ou incomplètes sont fréquentes : champs vides dans les CRM, historiques clients partiels, ou absence de métadonnées. Ces lacunes biaisent les modèles d'IA, qui deviennent moins précis et favorisent les segments mieux renseignés.

Les formats incohérents posent également problème : des dates saisies différemment (15/12/2025 vs. 12/15/2025), des unités de mesure variables ou des nomenclatures produits divergentes entre services entraînent des erreurs lors de la consolidation. Cela complique aussi la réutilisation des données pour différents cas d'usage IA.

Les doublons et redondances - comme des fiches clients multiples ou des produits dupliqués - faussent les analyses en sur-représentant certains profils. Les données obsolètes, telles que des adresses périmées ou des catalogues dépassés, peuvent conduire à des recommandations erronées et exposer les entreprises à des risques de non-conformité au RGPD. Enfin, le biais de données, souvent lié à une sous-représentation de certains segments dans les historiques, produit des modèles d'IA peu équitables, avec des conséquences potentielles sur la réputation. Ces problèmes montrent clairement l'importance d'une gestion stricte des données pour garantir leur fiabilité.

Au-delà des problèmes techniques, des failles organisationnelles aggravent la situation. Le manque de gouvernance des données est identifié comme le principal obstacle à l'adoption de l'IA par 62 % des répondants dans une étude menée par Precisely en 2024. Sans règles claires, sans responsables désignés (comme les data owners ou data stewards), et avec des droits d'accès mal définis, les entreprises peinent à tracer, corriger et sécuriser leurs données à grande échelle. Cette absence de cadre favorise la création de silos de données : chaque département utilise ses propres outils sans coordination, ce qui multiplie les incohérences et réduit les opportunités.

La pénurie de talents qualifiés complique encore les choses. Les experts comme les data engineers, data scientists ou data stewards, capables de gérer efficacement les outils d'IA, sont rares. Cela force les équipes à s'appuyer sur des processus manuels, longs et sujets aux erreurs, qui peinent à suivre l'explosion des volumes de données. En conséquence, la collecte, l'organisation et l'étiquetage des données absorbent jusqu'à 80 % du temps d'un projet d'IA, freinant ainsi son avancement[2]. Cette situation explique pourquoi 67 % des entreprises déclarent ne pas avoir pleinement confiance dans les données utilisées pour leurs décisions, contre 55 % l'année précédente.

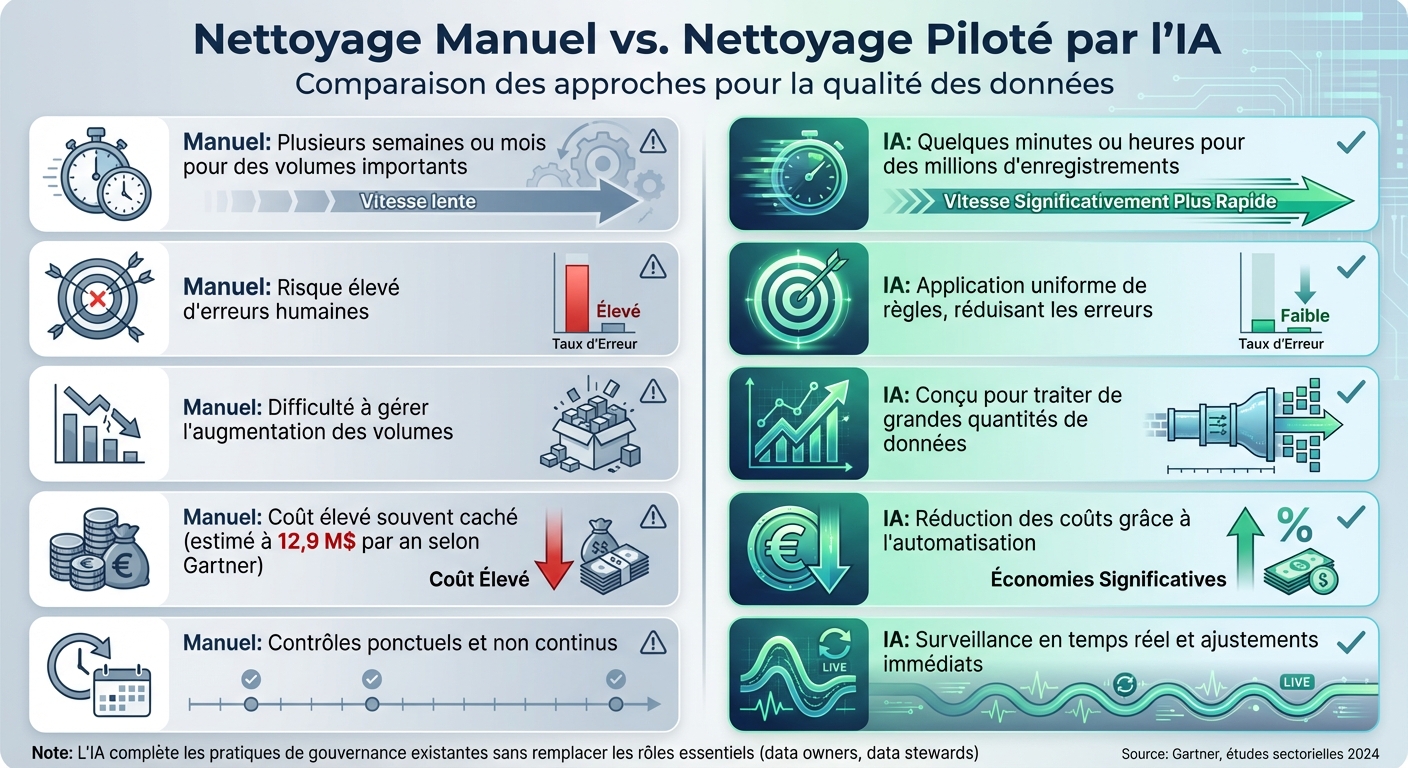

Comparaison nettoyage manuel vs IA pour la qualité des données

Pour relever les défis liés à la qualité des données, l'intelligence artificielle propose des solutions pratiques et efficaces. Ces technologies automatisent les tâches répétitives et détectent les incohérences dans de vastes ensembles de données, mettant en lumière des erreurs qui pourraient échapper à une analyse humaine.

L'IA offre plusieurs approches pour nettoyer et standardiser les données dès le départ. Par exemple, des modèles d'apprentissage automatique détectent automatiquement les anomalies en identifiant des écarts par rapport à un comportement attendu. Cela peut inclure des factures anormalement élevées ou des dates incorrectes[2].

La normalisation des données est une autre méthode clé. Grâce à des algorithmes intelligents, des formats variés (comme les adresses, IBAN ou dates) sont convertis en standards uniformes, renforçant ainsi la cohérence des données. Prenons l'exemple d'une entreprise qui a utilisé l'IA pour classifier ses produits et enrichir automatiquement ses fiches produits avec des informations manquantes. Résultat ? Un taux d'accès aux données passé de 40 % à 98 %.

Pour éliminer les doublons, l'IA s'appuie sur des techniques de correspondance floue et des embeddings. Ces outils comparent plusieurs champs (nom, adresse, SIRET, IBAN) pour identifier les enregistrements identiques. Grâce au traitement du langage naturel, ils prennent en compte les différences comme les accents ou les abréviations (Bd, Av, SARL, etc.) et fusionnent les informations en un seul « enregistrement d'or ». Les entreprises qui adoptent cette approche constatent souvent une réduction de 20 à 40 % des doublons dans leurs bases de données clients[2].

Pour combler les valeurs manquantes, l'IA utilise des algorithmes d'imputation, tels que la régression ou les k-plus proches voisins. Ces techniques analysent les corrélations dans les données pour estimer et remplir les champs vides, garantissant une base de données plus complète et fiable.

L'IA joue également un rôle dans l'identification et la correction des biais. En examinant les distributions déséquilibrées et en comparant les résultats entre différents groupes (par exemple, régions ou tranches d'âge), elle met en lumière les biais et propose des solutions pour équilibrer les données. Cela permet non seulement de mieux représenter toutes les populations, mais aussi de respecter les exigences du RGPD et les recommandations de la CNIL.

En résumé, ces méthodes permettent une automatisation bien plus efficace que les approches manuelles, souvent longues et sujettes à des erreurs.

Voici une comparaison des approches traditionnelles et assistées par l'IA pour le nettoyage des données :

| Critère | Nettoyage manuel | Nettoyage piloté par l'IA |

|---|---|---|

| Vitesse | Plusieurs semaines ou mois pour des volumes importants | Quelques minutes ou heures pour des millions d'enregistrements |

| Précision | Risque élevé d'erreurs humaines | Application uniforme de règles, réduisant les erreurs |

| Évolutivité | Difficulté à gérer l'augmentation des volumes | Conçu pour traiter de grandes quantités de données |

| Coût | Coût élevé souvent caché (estimé à 12,9 M$ par an selon Gartner) | Réduction des coûts grâce à l'automatisation |

| Réactivité | Contrôles ponctuels et non continus | Surveillance en temps réel et ajustements immédiats |

Cette comparaison montre que l'IA ne remplace pas les pratiques de gouvernance existantes, mais les complète. Les rôles comme ceux des data owners et data stewards restent essentiels, tout comme les catalogues de données. Cependant, l'IA apporte une couche supplémentaire grâce à des contrôles auto-apprenants et une automatisation avancée.

Par exemple, des outils tels qu'Akeneo PIM intègrent des workflows de validation en temps réel, identifient les anomalies et surveillent des indicateurs clés (comme le taux de complétude ou la pertinence). Cela libère les équipes, leur permettant de se concentrer sur des tâches à plus forte valeur ajoutée, tout en garantissant une qualité de données optimale.

Améliorer la qualité des données grâce à l'IA ne se limite pas à un simple ajustement technique. Cela se traduit par des résultats concrets qui impactent directement les performances des entreprises. En automatisant et en affinant la collecte et le traitement des données, l'IA contribue à des décisions plus éclairées et à une gestion des coûts plus efficace.

Des données fiables et cohérentes éliminent les biais et erreurs dans les modèles d'entraînement, ce qui améliore la précision des prédictions et des analyses. Cela peut avoir des impacts directs : moins de faux positifs dans la détection de fraudes, des prévisions de ventes plus fiables ou encore des recommandations produits parfaitement ciblées. À titre d'exemple, une entreprise du secteur industriel a vu son taux d'accès à des informations exploitables bondir de 40 % à 98 % grâce à la standardisation des formats et à l'intégration de modèles d'IA.

L'automatisation des processus liés à la qualité des données, comme la vérification des formats, la détection des doublons ou encore l'enrichissement des informations, permet de réduire les coûts opérationnels tout en libérant les équipes pour des missions plus stratégiques[2]. En parallèle, cette automatisation réduit les erreurs coûteuses, qu'il s'agisse de reprises, de réclamations clients ou de pénalités financières, particulièrement dans des secteurs réglementés comme la finance, la santé ou le secteur public en France.

Les chiffres sont parlants : Gartner estime que des données de mauvaise qualité coûtent chaque année des millions d'euros aux entreprises[2]. L'IA, en accélérant les cycles de validation, permet de réduire des processus comme l'intégration de nouveaux clients ou produits, passant de plusieurs jours à seulement quelques heures[2]. De plus, la préparation des données, qui représente souvent jusqu'à 80 % du temps d'un projet d'IA, est considérablement optimisée, laissant davantage de temps pour l'analyse et les applications métiers[2].

| Indicateur | Avant l'IA | Après l'IA |

|---|---|---|

| Taux d'accès aux données exploitables | 40 % | 98 % |

| Temps de préparation des données | Jusqu'à 80 % du projet[2] | Réduction significative |

| Évaluation de la qualité des données | 77 % considéraient leur qualité comme « moyenne » ou pire | Amélioration notable en complétude et cohérence |

| Confiance dans les données | 67 % des utilisateurs doutaient de leur fiabilité | Fiabilité renforcée pour des décisions plus sûres |

| Temps de mise sur le marché | Plusieurs jours pour un catalogue complet | Quelques heures grâce à l'automatisation[2] |

Ces résultats illustrent clairement comment l'IA transforme la gestion des données. En France, les entreprises peuvent ainsi mieux maîtriser leurs coûts, gagner du temps et prendre des décisions avec une précision accrue, tout en s'appuyant sur des données fiables et exploitables.

Après avoir examiné les méthodes et bénéfices liés à l’utilisation de l’IA pour améliorer la qualité des données, intéressons-nous aux perspectives d’avenir et au rôle joué par Zetos dans ce domaine.

L’avenir de la gestion des données repose sur la surveillance en temps réel. Les systèmes d’IA sont désormais capables d’analyser en continu les flux de données pour identifier immédiatement des anomalies, des changements dans les schémas ou des retards[2]. Cette capacité permet aux entreprises françaises de corriger des erreurs en quelques minutes au lieu de plusieurs jours. Par exemple, cela peut éviter des promotions erronées ou des informations incorrectes sur les stocks, sources fréquentes de retours coûteux.

La gouvernance assistée par IA est une autre avancée majeure. Les modèles d’IA peuvent classer automatiquement les données sensibles, comme celles couvertes par le RGPD ou liées à la santé, suggérer des responsables de données et signaler les violations de politiques. Ce progrès répond à une problématique clé : 62 % des entreprises identifient la gouvernance comme le principal frein à l’adoption de l’IA. En parallèle, les pipelines auto-réparateurs permettent à l’IA d’effectuer des corrections automatiques, comme basculer vers des sources de secours, convertir des formats ou revenir à une version précédente des données dès qu’une anomalie est détectée. Ces innovations garantissent des données exploitables en permanence[2].

Les réglementations européennes à venir imposent d’intégrer dès le départ des principes comme la confidentialité, l’équité et l’explicabilité. L’IA joue ici un rôle clé : elle peut détecter les données personnelles, appliquer des techniques comme la pseudonymisation et suivre l’historique des données pour justifier leur traitement. La lutte contre les biais devient également un impératif. Les entreprises françaises devront mesurer et corriger la représentativité de leurs jeux de données, notamment pour des applications comme le scoring de crédit, la gestion des ressources humaines ou la tarification. Ces nouvelles exigences font de la qualité des données un enjeu stratégique pour adopter l’IA de manière responsable.

Créée par trois entrepreneurs, Zetos intègre la qualité des données dès le début dans les projets qu’elle développe, qu’il s’agisse de sites web, d’applications mobiles ou de produits d’IA destinés aux entrepreneurs français. Grâce à des API d’IA, l’équipe est capable de normaliser les adresses, détecter les saisies incohérentes ou frauduleuses lors de la création de comptes, et compléter automatiquement les attributs des catalogues dans les back-offices e-commerce.

Pour les PME qui n’ont pas de département data en interne, Zetos propose des architectures standardisées. Celles-ci incluent des bases de données cloud, une gouvernance de base (gestion des accès, rétention des données, consentement) et des composants d’IA prêts à l’emploi. Cette solution permet aux entreprises de respecter les réglementations françaises et européennes tout en limitant les investissements initiaux. Avec un taux de recommandation client de 96 % et plus de 100 projets réalisés, Zetos aide ses clients à suivre des indicateurs clés comme le taux d’enregistrements incomplets, le délai de détection et correction des problèmes, ou encore l’impact sur les conversions. Ces résultats démontrent directement le retour sur investissement en euros[2].

L'intelligence artificielle bouleverse la manière dont les entreprises gèrent la qualité des données. Elle permet de corriger des pertes financières importantes causées par des données de mauvaise qualité, estimées à plusieurs millions d'euros chaque année[2]. Grâce à l'IA, la détection d'anomalies, le remplissage des champs manquants et la validation en temps réel sont automatisés. Résultat : le temps de préparation des données peut être réduit jusqu'à 80 %, libérant ainsi les équipes pour des missions plus stratégiques[2].

En 2024, 77 % des entreprises considèrent que leur qualité de données est « moyenne » ou « médiocre », une hausse par rapport à 66 % en 2023. Cependant, celles qui adoptent l'IA constatent une amélioration spectaculaire : leur accès à l'information passe de 40 % à 98 %. Comme le souligne Josh Rogers, PDG de Precisely :

Pour tirer pleinement parti de l'analytique et de l'IA, les entreprises doivent investir dans l'intégrité des données face au déclin de la confiance.

Cette évolution n'est plus un choix. En effet, 62 % des organisations identifient le manque de gouvernance comme le principal obstacle à l'adoption de l'IA.

Dans ce contexte, intégrer l'IA devient une nécessité pour rester compétitif. Zetos accompagne les entreprises françaises dans cette transformation. Avec plus de 100 projets à son actif et un taux de recommandation de 96 %, ce studio digital met la qualité des données au cœur de ses solutions. Que ce soit pour normaliser des adresses, détecter des saisies frauduleuses ou enrichir automatiquement des catalogues, Zetos propose des architectures adaptées aux PME, même sans département dédié à la data.

Prenez contact avec Zetos dès maintenant pour transformer vos données en un véritable atout stratégique. Profitez de solutions sur mesure, conformes aux réglementations françaises et européennes, pour booster vos performances et atteindre vos objectifs.

L'intelligence artificielle transforme la gestion des données en entreprise en rendant leur traitement plus rapide et précis. En automatisant des tâches comme la collecte, le nettoyage et l'organisation des données, elle réduit considérablement les erreurs tout en améliorant la fiabilité des informations essentielles au quotidien.

En plus de cela, l'IA assure une cohérence des données irréprochable et veille à leur conformité avec les réglementations locales. Ces atouts permettent aux entreprises françaises de prendre des décisions stratégiques plus éclairées, tout en renforçant leur compétitivité dans un monde de plus en plus numérique.

Les entreprises doivent relever plusieurs défis liés à la gestion de leurs données. L’un des plus importants est d’assurer la qualité et la cohérence des données, des éléments indispensables pour garantir des analyses fiables et pertinentes. Sans cette base solide, les décisions prises risquent d’être erronées ou mal informées.

Par ailleurs, établir une gouvernance efficace et se conformer aux réglementations en vigueur sont des priorités incontournables. Ces exigences ne sont pas seulement légales, elles participent aussi à renforcer la confiance des parties prenantes et à limiter les risques.

Un autre point clé concerne la formation des équipes. Il est essentiel que les collaborateurs puissent maîtriser les outils basés sur l’intelligence artificielle (IA) afin d’en exploiter tout le potentiel. Cela demande non seulement des compétences techniques, mais aussi une compréhension des impacts stratégiques de ces outils.

Enfin, pour maximiser les bénéfices de l’IA, il est crucial de l’intégrer de manière fluide dans les processus existants. Une intégration bien pensée permet d’améliorer la productivité tout en évitant de perturber les opérations quotidiennes. Chaque étape doit être soigneusement planifiée pour minimiser les frictions et maximiser les résultats.

L'intelligence artificielle s'appuie sur plusieurs méthodes pour repérer et corriger les biais présents dans les données. Parmi ces techniques, l'audit algorithmique joue un rôle clé : il examine les modèles pour déceler d'éventuels biais. Une autre approche courante est la normalisation des données, qui vise à réduire les écarts entre différentes sources afin d'assurer une meilleure cohérence.

En complément, utiliser des jeux de données variés est essentiel pour garantir une représentativité plus équilibrée. Par ailleurs, certains algorithmes d'apprentissage automatique sont spécialement conçus pour minimiser les biais. Ces stratégies combinées contribuent à améliorer la fiabilité des données, tout en renforçant leur justesse, ce qui les rend plus utiles et pertinentes pour les entreprises.